“La tecnología”

La máquina de Babbage

Con el avance a saltos de la tecnología, a finales del siglo

XVIII, las tablas matemáticas fueron adquiriendo creciente importancia como

ayuda para el cálculo. Esas tablas solían estar plagadas de errores, imputables

tanto a la ejecución de las cuentas como al proceso de impresión. El sistema

empleado para el cálculo de esas tablas era el "Método de las

Diferencias", cuya característica era basar todo cálculo en la adición,

sumando cantidades, por compleja que fuera la función.

Tarjetas perforadoras

Las tarjetas perforadas son un medio barato y eficaz para la

grabación de datos capaces de ser procesadas por medios mecánicos.

Las tarjetas perforadas fueron usadas por primera vez

alrededor de 1725 por Basile Bouchon y Jean-Baptiste Falcon como una forma más

robusta de los rollos de papel perforados usados en ese entonces para controlar

telares textiles en Francia. Esta técnica fue enormemente mejorada por Joseph

Marie Jacquard en su telar de Jacquard en 1801. Charles Babbage lanzó la idea

del uso de las tarjetas perforadas como un modo de controlar una calculadora

mecánica que él mismo diseñó.

Tubo de vacío

El tubo de vacío es un componente electrónico que amplifica,

modifica o crea una señal eléctrica por el control de los electrones en un

espacio a baja presión, cercano al vacío.

Los tubos de vacío fueron un descubrimiento crítico en el

desarrollo de la tecnología electrónica que desembocó en la comercialización de

Radios, televisión, radar, reproducción de sonido, grandes redes telefónicas,

computadoras analógicas y digitales, etc.

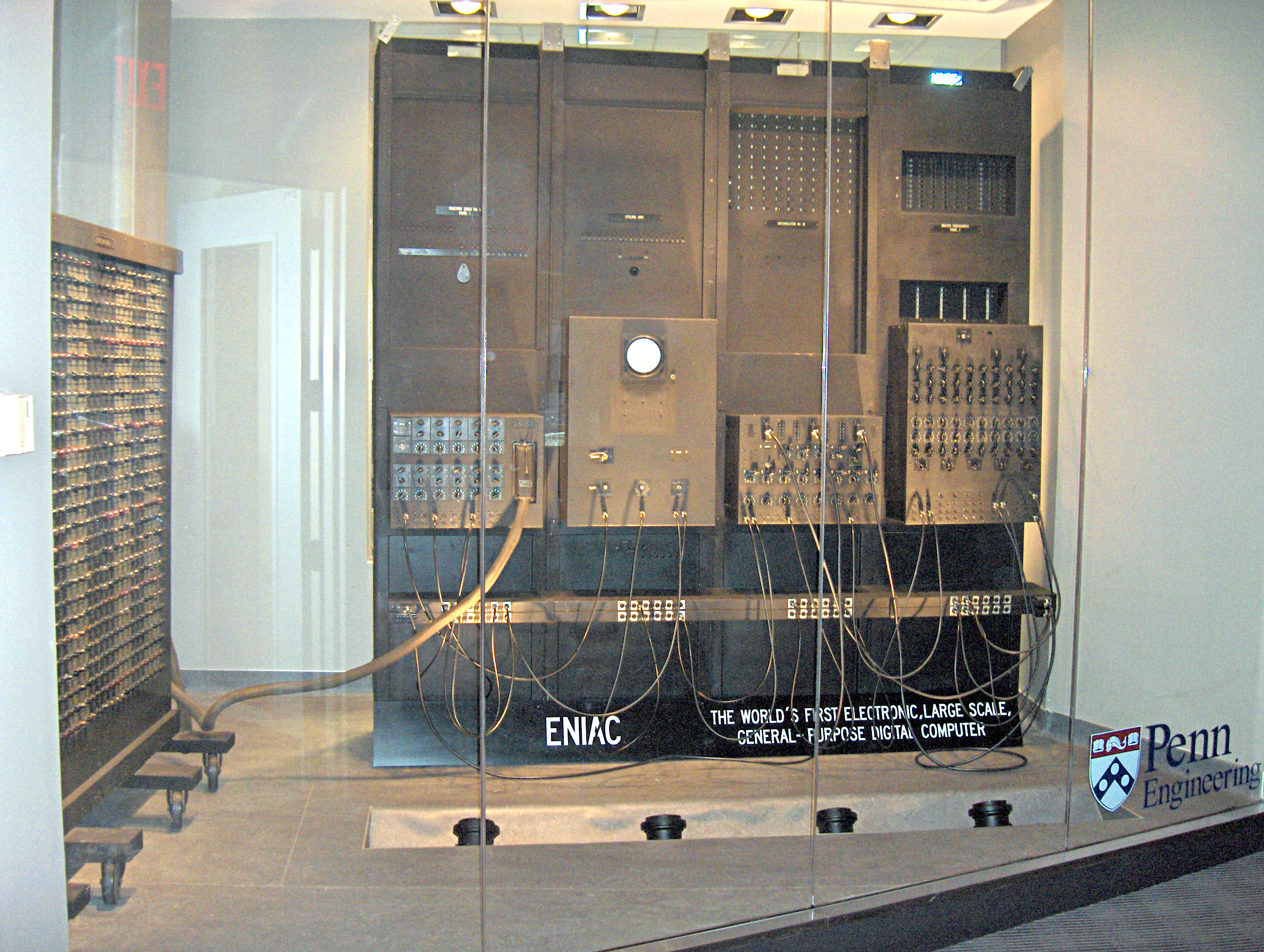

Eniac

(Electronica

Numeral Integrator and Computer)

El ENIAC nació en 1943, aunque no se

terminó de construir hasta 1946, fue un contrato entre el ejército de EE.UU y

sus desarrolladores John Mauchly y John Presper Eckert, llamado "Proyecto

PX". El ENIAC fue un ordenador electrónico

digital con fines generales a gran escala. Fue en su época la máquina más grande

del mundo, compuesto de 17468 tubos de vacío.

Éste estaba dividido

en 30 unidades autónomas, 20 de las cuales eran llamada acumuladores. Cada

acumulador era una máquina de sumar 10 dígitos a gran velocidad y que podía

almacenar sus propios cálculos.

Circuito integrado

La idea de circuito integrado nace de la necesidad de

reducir los circuitos eléctricos a uno mucho más sencillo y pequeño. Gracias a

ellos, se evitaron la multitud de problemas que se daban a la hora de fabricar

un circuito, como por ejemplo, que alguna de las miles de soldaduras que había

que realizar estuviera defectuosa, o la reducción del espacio que ocupaban las

válvulas de vacío, las cuales se vieron rápidamente obsoletas gracias a las

mejoras que supuso la introducción de los circuitos integrados.

Actualmente se utilizan en prácticamente todas las

tecnologías. Básicamente, los circuitos integrados, también llamados

"chips", son una pequeña pastilla de material semiconductor sobre la

que se integran circuitos en miniatura y se protegen con encapsulados de

plástico, cerámica o metal.

El creador del primer circuito integrado, fue el ingeniero

electrónico estadounidense Jack Kilby, en el año 1959, pocos meses después de

ser contratado por Texas Instruments. Se trataba de un dispositivo que

integraba seis transistores sobre una misma base semiconductora para formar un

oscilador de rotación de fase. A los 77 años, en el año 2000, Kilby fue

galardonado con el Premio Nobel de Física por su contribución al desarrollo de

la tecnología de la información.

Microprocesador

El microprocesador es el circuito integrado más importante.

Está formado por millones de transistores integrados. Incorpora en su interior

una unidad central de proceso (CPU) permitiendo enlazar otros dispositivos.

Para realizar su trabajo debe ejecutar paso a paso un programa que consiste en

una secuencia de números binarios o instrucciones, almacenándolas en uno o más

elementos de memoria, generalmente externos al mismo. La aplicación más

importante de los microprocesadores, el ordenador.

Alan Turing

"El inglés Alan Turing (1912-1954) puede ser

considerado el padre de la Inteligencia Artificial.

"Durante los años de la segunda guerra mundial, Turing

colaboró en el diseño de una máquina llamada la ‘Bomba’ que exploraba las

combinaciones posibles generadas por la máquina codificadora alemana ‘Enigma’.

Inteligencia artificial

el término "inteligencia artificial" fue acuñado

formalmente en 1956 durante la conferencia de Darthmounth, más para entonces ya

se había estado trabajando en ello durante cinco años en los cuales se había

propuesto muchas definiciones distintas que en ningún caso habían logrado ser

aceptadas totalmente por la comunidad investigadora. La AI es una de las

disciplinas más nuevas que junto con la genética moderna es el campo en que la

mayoría de los científicos " más les gustaría trabajar".

Una de las grandes razones por la cuales se realiza el estudio

de la IA es él poder aprender más acerca de nosotros mismos y a diferencia de

la psicología y de la filosofía que también centran su estudio de la

inteligencia, IA y sus esfuerzos por comprender este fenómeno están encaminados

tanto a la construcción de entidades de inteligentes como su comprensión.

Electrónica molecular

La electrónica molecular, a veces llamada moletrónica, es la

rama de la ciencia que estudia el uso de moléculas orgánicas en la electrónica.

Los primeros trabajos acerca de la transferencia de cargas

eléctricas entre moléculas fueron realizados por Robert Mulliken y Albert

Szent-Gyorgi en 1940. Sin embargo, el primer dispositivo moletrónico no fue

desarrollado hasta 1974, año en el que se construye un biestable de melanina.

En 1988 fue descrita una molécula capaz de actuar como un transistor de efecto

campo.

Electrónica molecular es el conjunto de comportamientos

electrónicos en estructuras que contienen moléculas que dependen de la

organización molecular característica del espacio.

Steve Jobs

(Los Altos, California, 1955 - Los Ángeles, 2011)

Informático y empresario estadounidense. Padre del primer ordenador personal

(el Apple I) y fundador de Apple Computer, probablemente la empresa más

innovadora del sector, este mago de la informática fue uno de los más

influyentes de la vertiginosa escalada tecnológica en que aún vive el mundo

actual, contribuyendo decisivamente a la popularización de la informática. Sus

ideas visionarias en el campo de los ordenadores personales, la música digital

o la telefonía móvil revolucionaron los mercados y los hábitos de millones de

personas durante más de cuatro décadas.

Steve Wozniak

(Nacido el 11 de

agosto de 1950) es un ingeniero de software convertido en filántropo. Sus

inventos y máquinas están reconocidos como grandes contribuyentes a la

revolución del ordenador personal en los años setenta. Wozniak fundó Apple

Computer junto con Steve Jobs en 1976 y creó los ordenadores Apple I y Apple II

a mediados de los años setenta. El Apple II se convirtió en el ordenador mejor

vendido de los años setenta y de los primeros ochenta, y es a menudo reconocido

como el primer ordenador personal popular.

Es muy importante destacar que la tecnología es muy importante

hoy en día y cabe señalar que sin duda ésta seguirá aportando cosas nuevas e

interesantes para nuestra vida, y esta de más decir que es muy buena siempre

y cuando sea utilizada de la manera

correcta.

Todo lo que aparece aquí es muy bueno pata conocer la evolución de la tecnología.

No hay comentarios:

Publicar un comentario